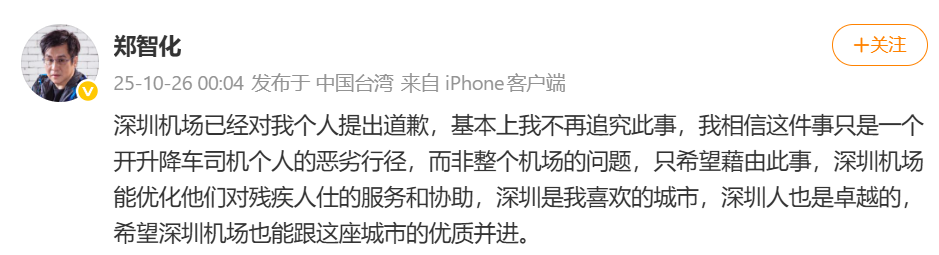

突破瓶颈!中国成功研制新型芯片

导读:最近和做AI行业的朋友吃饭,聊到最头疼的事几乎异口同声——“算力像吞金兽”。训练个大模型要烧一套房的电费,工厂机器人实时识别零件得连三台服务器,大家都在等:有没有什么“黑科

突破瓶颈!中国成功研制新型芯片

最近和做AI行业的朋友吃饭,聊到最头疼的事几乎异口同声——“算力像吞金兽”。训练个大模型要烧一套房的电费,工厂机器人实时识别零件得连三台服务器,大家都在等:有没有什么“黑科技”能给算力“减减负”?昨天北大传来的消息,说不定能给这个问题画个新句号。

2025年10月,北京大学人工智能研究院孙仲团队联合集成电路学院,把“模拟计算”这个藏在实验室几十年的“老概念”,翻出了新花样——他们用阻变存储器做核心,造出一款模拟矩阵计算芯片,最关键的突破是:把模拟计算的精度一举提到了24位定点!

可能有人没听过“模拟计算”,我给大家掰扯两句:咱们现在用的电脑手机都是“数字计算”,拆成0和1一步步算,像搭积木;但模拟计算不一样,直接用物理现象对应数据——比如用电阻变化代表数值,像用尺子量长度,不用拆成小数位。这方法的好处是“快”且“省”,但过去最大的问题是“不准”:精度大多停在8-16位,连复杂数学题都算不对,更别说AI训练了。

这次北大团队把精度干到24位,意味着什么?举个直观例子:以前模拟芯片算“1+1”可能偏差到“1.2”,现在能精确到“1.000000”——足够处理AI模型里的核心运算“矩阵乘法”了,而这一步占了AI训练80%的能耗。

孙仲老师跟我说,项目做了三年,最苦的时候团队在实验室熬了三个月,天天调阻变存储器的参数。“不是没遇到瓶颈,”他说,“但想到模拟计算能给AI减负担,就觉得得啃下来。”

也有业内朋友提醒:芯片要落地还有几道坎——比如怎么和数字系统对接,成本能不能降到工业级,可靠性要测多久。但不管怎么说,能把精度提上来,已经是把“不可能”变成了“有可能”。

至于应用前景,孙仲老师说得实在:“不是取代数字芯片,是做‘帮手’。”比如机器人实时避障,模拟计算比数字芯片快30%、省一半电;AI模型训练时用它处理矩阵乘法,能耗降四成。“我们想让AI不仅‘聪明’,还‘省钱’。”

其实这两年中国芯片突破不少,但这种“从基础原理解决问题”的成果,特别提气。以前说“卡脖子”,现在我们开始在“无人区”找新路了——模拟计算不是别人玩剩下的,是我们自己啃出来的突破。说不定再过两年,你用AI聊天、看工厂机器人干活,背后就有这款芯片在“出力”。

所谓“突破”,从来不是一下子翻座大山,而是把“瓶颈”变成“台阶”。这次北大的芯片,就是这样一级重要的台阶。毕竟,解决“算力能耗”的问题,从来不是买多少服务器,而是像一步一步把“不可能”变成“我能行”。